Eine einzige Plattform für all deinen Erfolg

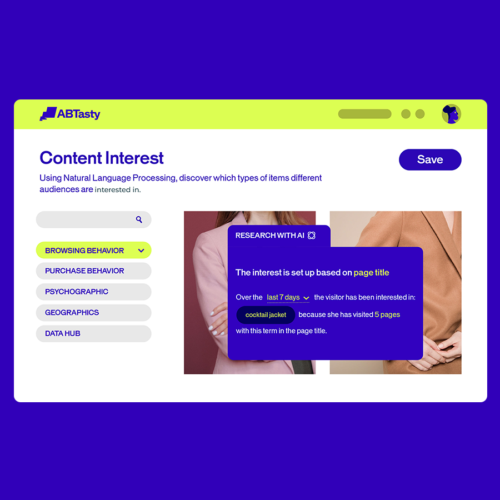

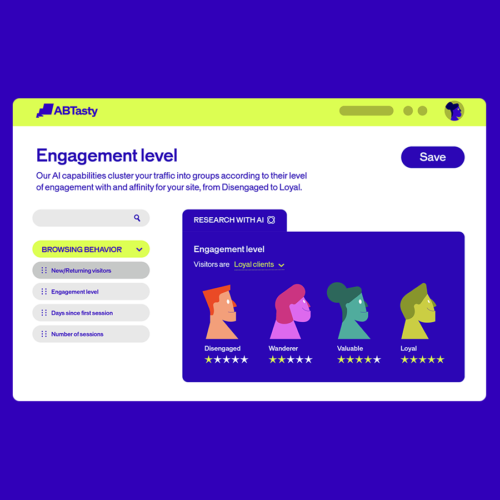

Testen neuer Features, Umsetzung von Ideen, Verbessern von Experiences. Unser Mindset: Experience Optimization durch und durch.

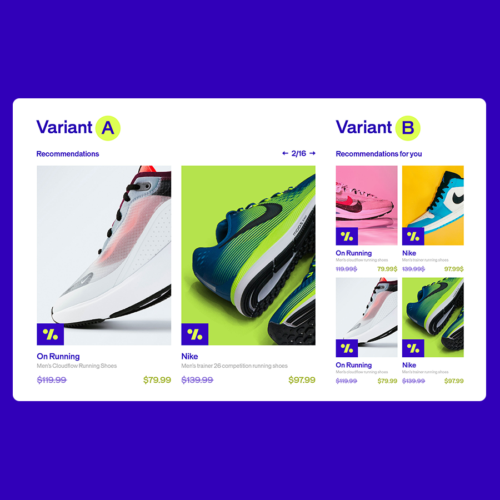

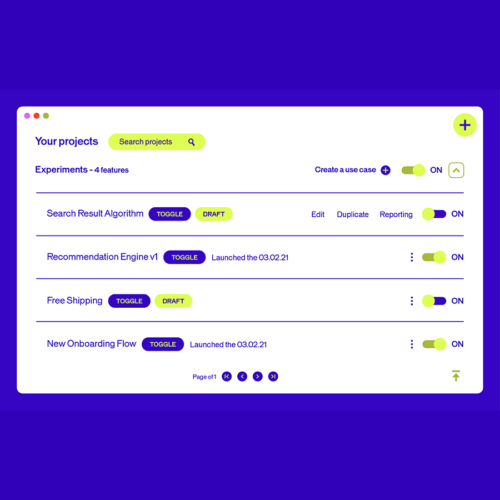

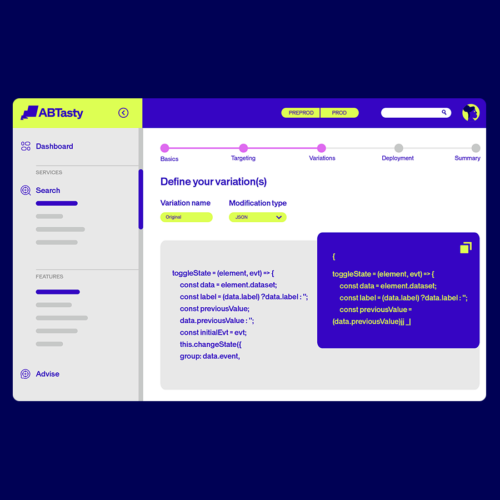

Web Experimentation

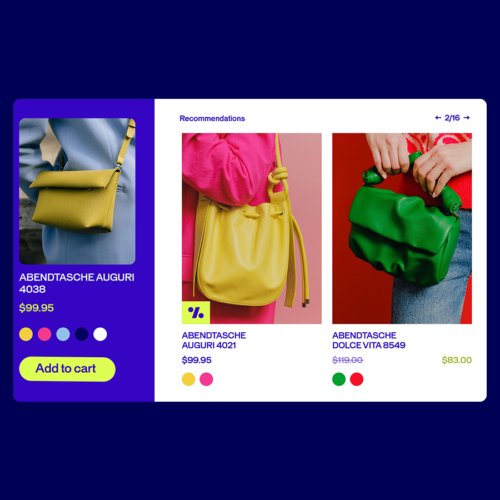

Umfangreiche Testing-Möglichkeiten entlang deiner Journey bieten die Möglichkeit, einfach zu starten oder komplex zu werden.

- Die Anpassung an sich verändernde Kundenerwartungen wird mühelos. Neue Experiences schaffen, bestehende in Frage stellen und Ideen ohne technische Barrieren umsetzen.

- Triff Entscheidungen mit der Gewissheit, dass deine Conversions sicher sind.

Möchtest du AB Tasty in Aktion sehen?

Erstelle End-to-End-Erlebnisse, die das Wachstum über alle digitalen Kanäle hinweg fördern.

Customer Experience Optimization: Versuch macht klug

Schneller wachsen mit AB Tasty

Erhalte eine individuelle Web Demo unserer Customer Experience Optimization Platform.