Que sont les tests A/B?

Le test A/B, aussi connu sous le nom de test split, implique un processus de test et de comparaison de deux versions différentes d’un site Web ou d’une fonctionnalité afin de voir laquelle fonctionne mieux.

Les versions ou variations A et B sont présentées aléatoirement aux utilisateurs où une partie des utilisateurs sont dirigés vers la première version tandis que le reste, vers la seconde.

Une analyse statistique des résultats de chaque variation est effectuée pour voir laquelle fonctionne le mieux; par exemple, laquelle a reçu le plus de clics, le taux de conversion et cetera. De cette façon, vous pourrez vérifier votre hypothèse construite au début de l’expérience, où les résultats de votre test A/B vous permettront de valider ou de rejeter cette hypothèse.

Les tests A/B peuvent être effectués sur deux versions assez similaires avec seulement un petit changement au sein du site Web, mais ce changement pourrait amener d’énormes conséquences, par exemple, en engagement des utilisateurs et de taux de conversion.

Prenons un exemple.

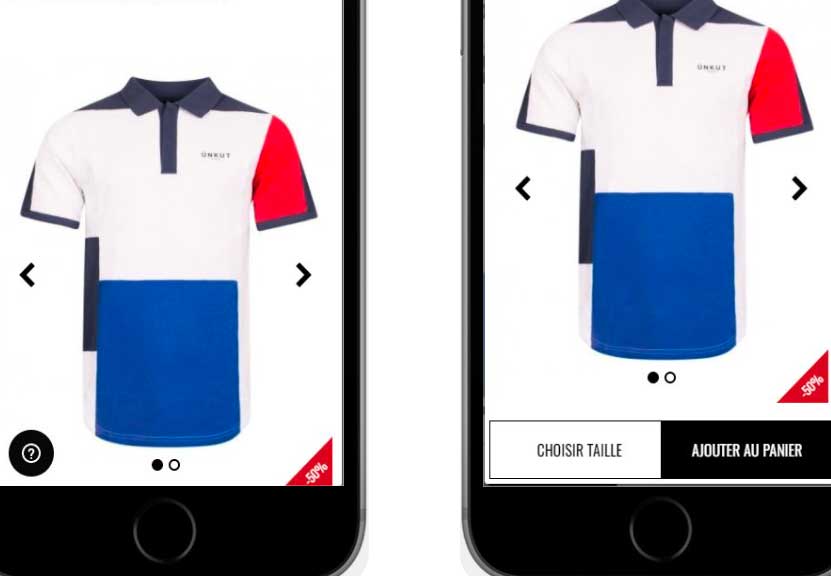

Imaginez que nous voulions tester si l’ajout de boutons comme « ajouter au panier » et « choisir la taille » pour faciliter la navigation, comme dans l’image de droite, connue sous le nom de « version expérimentale », se traduira par plus de clics et d’achats que l’image de gauche, la version de contrôle.

Cette hypothèse, faite avant le lancement des variations, est appelée « hypothèse ». La variation que vous créez sera fondée sur cette hypothèse pour la tester par rapport au témoin.

Ainsi, les données seront recueillies pour prouver, ou non, cette hypothèse, et pour conclure laquelle améliorera les retours de votre entreprise. En d’autres termes, vous serez en mesure de mesurer quel ensemble d’utilisateurs aura eu un taux de conversion plus élevé, avec précision statistique, selon la page vers laquelle ils ont été dirigés.

En savoir plus: Des études de cas de test A/B pour vous donner une idée de test A/B pour votre propre site Web.

Types de A/B tests

Il existe différents types de tests A/B, qui seront utilisés en fonction de vos besoins et objectifs particuliers:

- Test A/B classique – ce test utilise deux variations de vos pages sur le même URL pour comparer plusieurs variations d’un même élément.

- Split test – parfois les tests A/B et split sont utilisés de façon interchangeable, mais il y a une différence majeure : dans un split test, la variation modifiée est sur un URL différent, donc le trafic est dirigé entre le contrôle sur l’URL d’origine et les variations sur un URL différent (ce nouvel URL reste cachée aux utilisateurs).

- Test multivarié (MVT) – ce test mesure la portée de plusieurs changements sur une même page Web afin de déduire quelle combinaison de variables fonctionne la meilleure de toutes les combinaisons possibles. Ce test est généralement plus compliqué à exécuter que les autres et nécessite un trafic important.

Statistiques de tests A/B

Les tests A/B sont basés sur des méthodes statistiques. Par conséquent, il est important de comprendre quelle approche statistique adopter pour effectuer un test A/B et tirer les bonnes conclusions pour vous aider à répondre aux besoins de votre entreprise.

Quel modèle statistique choisir ?

Il existe généralement deux approches principales utilisées par les testeurs A/B pour des retours statistiquement significatif: les tests fréquentistes et bayésiens.

L’approche fréquentiste est basée dans l’observation de données à un moment donné. L’analyse des résultats ne peut avoir lieu qu’à la fin du test, alors qu’une approche bayésienne est déductive et utilise davantage une approche prévisionnelle, ce qui vous permet d’analyser les résultats avant la fin du test.

Ainsi, dans une approche fréquentiste, lorsque vous concevez un test A/B, vous choisiriez la variation gagnante basée uniquement sur les résultats de cette expérience que vous avez exécutée, alors qu’une approche bayésienne prendrait l’information recueillie des expériences précédentes et l’utiliserai avec les données actuelles tirées du nouveau test pour en tirer une conclusion en conséquence.

Pour une meilleure comparaison et pour en savoir plus sur les différences entre ces deux approches, consultez cet article fréquentiste vs bayésien.

Afin d’analyser les résultats avec un degré de sûreté statistique suffisant, un seuil de 95 % (correspondant à une valeur-p de 0,05) est généralement adopté. L’objectif est de recueillir suffisamment de données pour être en mesure de faire des prévisions en toute confiance selon les résultats. En d’autres termes, assurez-vous que les pages Web que vous testez ont suffisamment de trafic.

La signification statistique indique que le résultat est très probablement non-aléatoire, et est attribué à une cause ou à une tendance précise. C’est le niveau de confiance (P) que la différence entre le contrôle et la variation n’est pas fortuite.

Ce niveau de confiance est obtenu grâce à un ensemble d’observations et représente le niveau de sûreté que le même résultat sera obtenu avec différentes données dans une expérience future similaire.

En savoir plus: A/B testing

Publiez que vos meilleures fonctionnalités grâce aux tests A/B

Le A/B testing est une excellente forme d’expérimentation. Le A/B testing avec feature flags est encore mieux.

Les Feature flags sont un outil de développement de software qui peut être utilisé pour activer ou désactiver les fonctionnalités sans déployer de code. Ils ont de nombreuses utilisations, dont nous avons déjà beaucoup parlé. L’un de ces cas d’utilisation est l’exécution d’expériences avec des tests A/B.

Bien que les tests A/B soient généralement utilisés pour les tests front-end sur votre site Web ou application, les tests A/B peuvent aussi aller plus loin et vous permettre de tester également les fonctionnalités de votre produit. Ainsi, les tests A/B sont bons pour tester les changements dits ‘cosmétiques’ sur votre site Web, mais que faire lorsque vous voulez tester les fonctionnalités back-end, y compris les nouvelles?

Voici les A/B tests pilotés par Feature flags. Cela signifie que vous pouvez tester vos fonctionnalités et cibler les utilisateurs en les divisant en différents segments. Nous aborderons en détail les tests côté serveur dans la prochaine section.

Dans ce cas ci, vous définirez les variations et attribuerez des pourcentages à chacune des variations. Les variations sont faites en utilisant une combinaison de différentes valeurs de flags. Ainsi, vous pouvez utiliser tous les flags disponibles dans votre système et les combiner pour tester ces diverses combinaisons et comment vos utilisateurs y répondent.

En livrant différentes versions simultanées de votre fonctionnalité à des portions prédéterminées du trafic, vous pourrez observer et utiliser les données extraites pour déterminer quelle version est la meilleure.

Les Feature flags ou les toggles utilisés de cette façon sont également appelés toggles d’expérience. Ceux-ci sont très dynamiques et sont susceptibles de rester dans le code quelques jours ou semaines, assez longtemps pour générer des résultats statistiquement significatifs requis pour les A/B tests.

Tests A/B serveur-side vs client-side

De plus, nous devons faire une distinction importante entre les tests côté client et côté serveur.

Alors que les tests côté client ne se produisent qu’au niveau du navigateur Web afin que vous soyez contraint de tester les variantes visuelles ou structurelles de votre site Web, les tests côté serveur se produisent avant même que les pages HTML soient rendues par le navigateur de l’utilisateur.

Travailler côté serveur signifie que vous pouvez exécuter des campagnes d’optimisation sur l’architecture de backend directement à partir du codage. Cela a d’énormes conséquences.

Le test côté client place un cookie dans votre navigateur pour vous identifier afin que lorsque vous revenez sur le site, il se souvienne de qui vous êtes et vous montre la même version du site que vous avez vu la première fois. Dans un monde où la tendance est d’aller cookieless, cela peut être difficile.

La performance est un autre problème.

Les tests côté client reposent sur des extraits javascript qui doivent être récupérés auprès d’un fournisseur tiers et exécutés pour appliquer des modifications. Cela peut conduire au flickering, également appelé FOOC (Flash of Original Content) et peut endommager l’expérience utilisateur et la validité de l’expérience. Découvrez comment éviter l’effet flicker.

Par contre, les tests côté serveur permettent de suivre tous les utilisateurs en fonction des identifiants d’utilisateur uniques que vous gérez en arrière-plan de la façon que vous préférez (p. ex., base de données d’utilisateurs pour les utilisateurs connectés, identifiant de session des visites ou cookies en dernier recours).

En savoir plus: Client-Side vs. Server-Side Experiments [Infographic]

avec ABTasty

Obtenez une démo personnalisée de la plateforme

Demander une démo