Si le nombre de visiteurs sur votre site web n’est pas aussi élevé que vous l’espériez, cela ne signifie pas que vous devez abandonner vos objectifs CRO.

À ce stade, vous avez probablement remarqué que la plupart des conseils en matière de CRO sont adaptés aux sites web à fort trafic. Heureusement, cela ne veut pas dire que vous ne pouvez pas optimiser ce dernier, même en ayant un trafic plus faible.

La vérité est que n’importe quel site web peut être optimisé : il vous suffit d’adapter votre stratégie d’optimisation à votre situation spécifique.

Dans cet article, nous aborderons :

Commençons par une analogie

Pour faciliter la compréhension de cet article, commençons par une analogie. Imaginez : plutôt que de mesurer deux variations et de choisir un gagnant, nous mesurons les performances de deux boxeurs et plaçons des paris sur qui remportera les 10 prochains rounds.

Comment choisir sur qui parier ?

Imaginons que le boxeur A et le boxeur B soient tous les deux des débutants que personne ne connaît. Après le premier round, vous devez faire votre choix. En fin de compte, vous allez très probablement parier sur le boxeur qui a remporté le premier round. Cela peut être risqué si la marge de victoire est faible, mais en fin de compte, vous n’avez pas d’autre moyen de prendre votre décision.

Maintenant, imaginez que le boxeur A est connu comme un champion, et le boxeur B est un challenger que vous ne connaissez pas. Votre connaissance sur le boxeur A est ce que l’on appelle un « prior », à savoir des informations que vous obtenez en amont et qui influencent votre décision.

Sur la base de cette connaissance préalable, vous serez plus enclin à parier sur le boxeur A en tant que champion pour les prochains rounds, même si le boxeur B remporte le premier round avec une marge très faible.

De plus, vous ne choisirez le boxeur B comme champion prédit que s’il remporte le premier round avec une marge importante. Plus votre connaissance préalable est forte, plus la marge doit être grande pour vous convaincre de changer votre pari.

Vous suivez ? Si c’est le cas, les paragraphes suivants seront faciles à comprendre et vous comprendrez vite d’où vient ce « seuil de 95 % ».

Maintenant, passons aux conseils pour optimiser votre site web à faible trafic.

1. Résoudre le problème : « Je n’atteins jamais le seuil de certitude de 95% »

C’est le mécontentement qui revient le plus souvent concernant le CRO sur des sites web à faible trafic et sur les pages à faible trafic de plus grands sites web.

Avant d’approfondir ce problème, commençons par répondre à la question suivante : d’où vient cette « règle d’or » des 95% ?

L’origine du seuil de certitude de 95%

Commençons notre explication avec une idée très simple : que se passerait-il si les stratégies d’optimisation étaient appliquées dès le premier jour ? Si deux variantes sans historique étaient créées en même temps, il n’y aurait pas de version « originale » contestée par un nouvel arrivant.

Cela vous obligerait à choisir la meilleure dès le départ.

Dans ce cas, la moindre différence de performance pourrait être prise en compte pour prendre une décision. Après un court test, vous choisiriez la variante avec la meilleure performance. Il ne serait pas bon de choisir la variante qui a une performance inférieure et, de plus, ce serait insensé d’attendre un seuil de certitude de 95% pour choisir un gagnant.

Mais en pratique, l’optimisation est réalisée bien après le lancement d’une entreprise.

Ainsi, dans la réalité, il existe une version A qui existe déjà et un nouveau challenger (version B) qui est créé.

Si le nouveau challenger (la version B) arrive et que la différence de performance entre les deux variantes n’est pas significative, vous n’aurez aucun problème à déclarer que la version B n’est « pas un gagnant ».

Les tests statistiques sont symétriques. Donc, si nous inversions les rôles, en échangeant A et B dans le test statistique, cela indiquerait que l’original n’est pas significativement meilleur que le challenger. L’aspect « non concluant » du test est symétrique.

Alors, pourquoi orientez-vous 100% du trafic vers l’original à la fin d’un test non concluant, en déclarant implicitement A comme gagnant ? Parce que vous avez pris en compte trois connaissances préalables :

- La version A était le choix initial. Il a été élaboré par le créateur de la page.

- La version A a déjà été mise en œuvre et techniquement approuvée. La version B n’est généralement qu’une maquette.

- La version A dispose de nombreuses données pour prouver sa valeur, tandis que B est un challenger avec des données limitées qui ne sont collectées que pendant la période de test.

Les points 1 et 2 sont les bases d’une stratégie de CRO, vous devrez donc aller au-delà de ces deux points. Le point 3 explique que la version A dispose de plus de données pour étayer sa performance. Cela permet de comprendre pourquoi vous faites plus confiance à la version A qu’à la version B.

Maintenant, vous comprenez que cette règle de seuil de certitude fixé à 95% est une façon d’expliquer des connaissances préalables. Et celles-ci proviennent principalement des données historiques.

Par conséquent, lors de l’optimisation d’une page à faible trafic, votre seuil de certitude devrait être inférieur à 95% car vos connaissances sur A sont plus faibles en raison de son trafic et de son ancienneté.

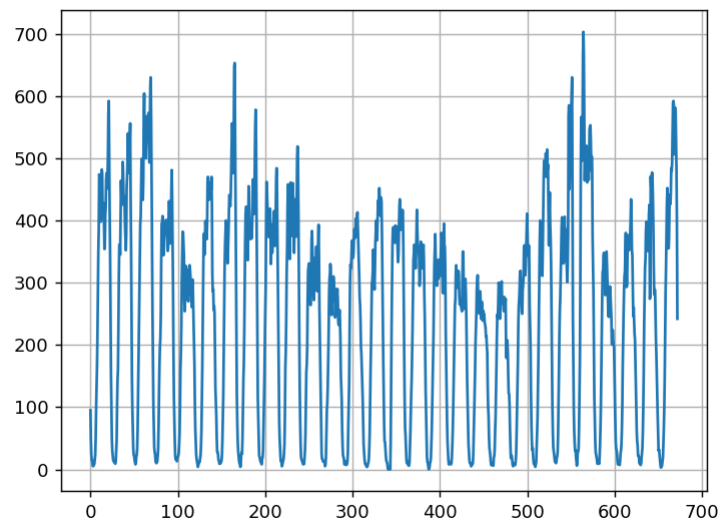

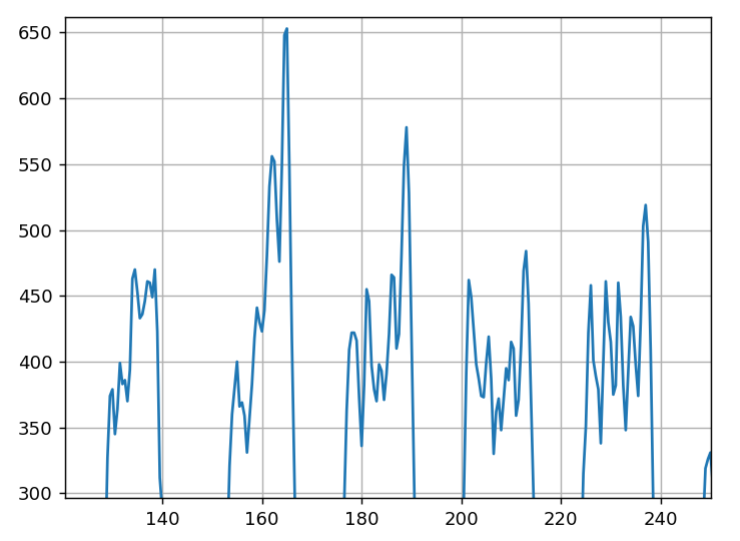

Ce seuil devrait être défini en fonction du volume du trafic qui a traversé le site web depuis son premier jour. Le problème avec cette approche, c’est que nous savons que les taux de conversion ne sont pas stables et qu’ils peuvent changer avec le temps. Pensez à la saisonnalité, par exemple l’afflux du Black Friday, les jours de congé, les périodes de Noël où l’activité augmente, etc. En raison de ces variations saisonnières, il n’est pas possible de comparer les performances à des périodes différentes.

C’est pourquoi les professionnels ne tiennent compte que des données pour la version A et la version B collectées pendant la même période, et ils fixent un seuil de certitude élevé (95%) pour accepter le challenger comme gagnant afin de formaliser les connaissances préalables solides en faveur de la version A.

Quel est le seuil de décision approprié lors d’un faible trafic ?

Il est difficile de suggérer un chiffre exact sur lequel se concentrer car cela dépend de votre tolérance au risque.

Selon le protocole de la méthode de » test d’hypothèse », on doit fixer une période de collecte de données, et analyser seulement à la fin de cette période.

Cela signifie que le critère d’arrêt d’un test n’est pas une mesure statistique ou basée sur un nombre spécifique. Le critère d’arrêt devrait être une période de temps qui se termine. Une fois la période terminée, vous devez examiner les statistiques pour prendre une décision appropriée.

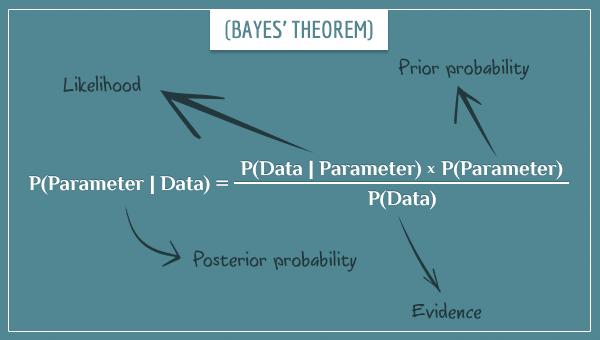

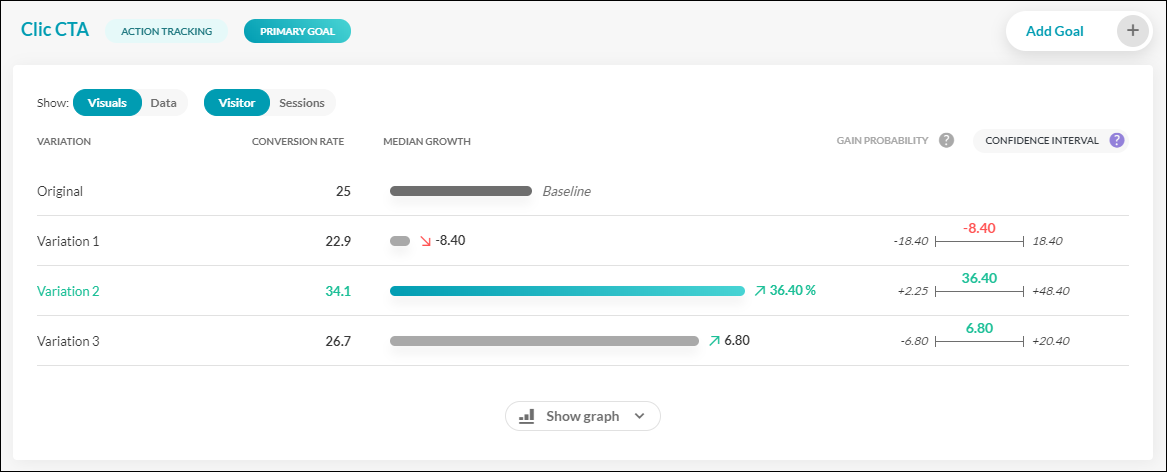

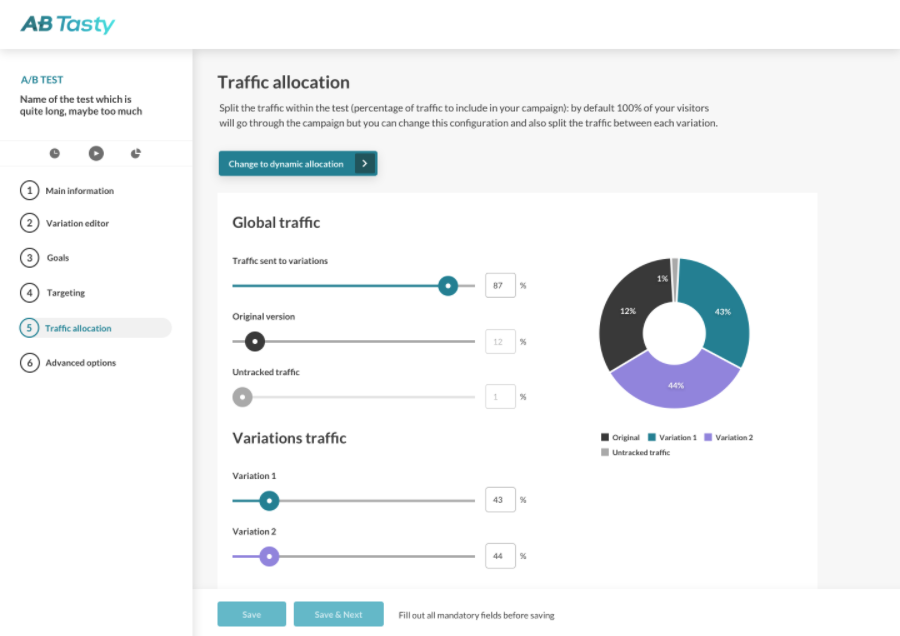

AB Tasty, notre logiciel d’optimisation de l’expérience client et de feature management, utilise la méthode bayésienne qui produit un indice de « chance de gagner”. Cet indice permet une interprétation directe des chances de gagner, plutôt que d’obtenir une P valeur qui elle a une signification très complexe.

En d’autres termes, l’indice de « chance de gagner » est la probabilité qu’une variation donnée soit meilleure que l’original.

Par conséquent, une « chance de gagner » de 95% signifie qu’il y a une probabilité de 95% que la variation donnée soit gagnante. Cela suppose que nous n’avons ni connaissance préalable, ni confiance spécifique dans l’original.

Le seuil de 95% lui-même est également un compromis par défaut entre la connaissance préalable que vous avez sur l’original et un certain niveau de tolérance au risque (cela aurait même pu être un seuil de 98%).

Bien qu’il soit difficile de donner un chiffre exact, voici une échelle approximative pour votre seuil :

- Nouvelles variations A et B : si vous avez un cas où la variation A et la variation B sont toutes les deux nouvelles, le seuil peut être très bas, jusqu’à 50 %. S’il n’y a pas de données antérieures sur les performances des variations et que vous devez faire un choix pour la mise en œuvre, même une chance de gagner de 51 % est meilleure que 49 %.

- Nouveau site web, faible trafic : si votre site web est nouveau et a très peu de trafic, vous avez probablement très peu de connaissances préalables sur la variation A (ici, la variation d’origine). Dans ce cas, fixer un seuil de 85 % est raisonnable. Cela signifie que si vous mettez de côté ce que vous savez déjà sur l’original, vous avez encore 85 % de chance de choisir le gagnant et seulement 15 % de chance de choisir une variation équivalente à l’original (avec une chance encore moindre qu’elle se comporte moins bien). Selon le contexte, un tel pari peut avoir du sens.

- Entreprise mature, faible trafic : si votre entreprise a une longue histoire mais un trafic faible, un seuil de 90 % est raisonnable. C’est parce qu’il y a encore peu de connaissances antérieures sur l’original.

- Entreprise mature, trafic élevé : si vous disposez de nombreuses données ou de connaissances préalables sur la variation A, un seuil de 95 % est approprié.

Le seuil d’origine de 95 % est bien trop élevé si votre entreprise a un faible trafic, car il y a peu de chances que vous l’atteigniez. Par conséquent, votre stratégie CRO n’aura aucun effet, et la prise de décision basée sur les données devient impossible.

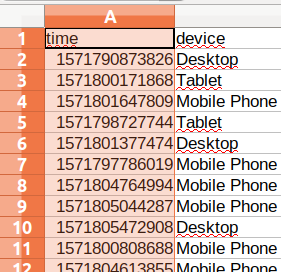

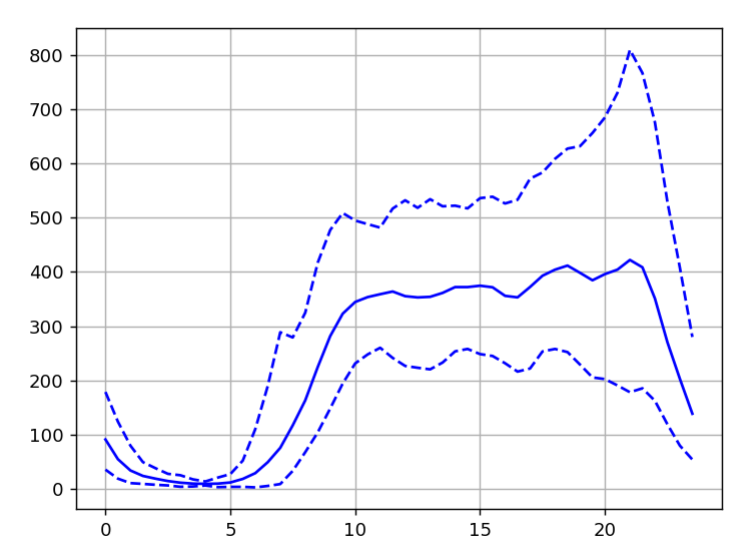

En utilisant AB Tasty comme plateforme d’expérimentation, vous recevrez un rapport comprenant la « chance de gagner » ainsi que d’autres informations statistiques concernant vos expériences. Il inclurait également l’intervalle de confiance sur le gain estimé, qui est un indicateur important. Les limites autour du gain estimé sont également calculées de manière bayésienne, ce qui signifie qu’elles peuvent être interprétées comme le meilleur et le pire scénario.

L’importance des statistiques bayésiennes

Maintenant que vous comprenez le sens précis du niveau de « certitude » de 95%, pourtant bien connu, vous êtes en mesure de sélectionner des seuils appropriés correspondant à votre cas particulier.

Il est important de se rappeler que cette approche ne fonctionne qu’avec les statistiques bayésiennes, car l’approche fréquentiste fournit des indices statistiques (tels que les P valeurs et les intervalles de confiance) qui ont un sens totalement différent et ne conviennent pas à la logique expliquée.

2. Les statistiques sont-elles valables avec de petits nombres ?

Oui, elles sont valables tant que vous ne mettez pas fin au test en fonction du résultat. Vous pouvez ignorer le readiness shield.

Rappelez-vous que le protocole de test indique qu’une fois que vous avez décidé d’une période de test, la seule raison de l’arrêter est lorsque ce délai est écoulé. Dans ce cas, les indices statistiques (« chance de gagner » et intervalle de confiance) sont vrais et utilisables.

Vous pensez peut-être : « D’accord, mais j’atteins rarement le seuil de certitude de 95%… »

Rappelez-vous que le seuil de 95% n’a pas besoin d’être le chiffre magique pour tous les cas. Si vous avez peu de trafic, il est probable que votre site web soit récent. Si vous vous référez au point précédent, vous pouvez consulter notre échelle suggérée pour différents scénarios.

Si vous avez peu de trafic en tant que nouvelle entreprise, vous pouvez certainement passer à un seuil plus bas (comme 90%). Le seuil est encore assez élevé car il est courant d’avoir plus confiance en une version originale qu’en une variante car elle est utilisée depuis plus longtemps.

Si vous avez affaire à deux variantes totalement nouvelles, à la fin de votre période de test, il sera plus facile de choisir la variante avec le plus grand nombre de conversions (sans utiliser un test statistique) puisqu’il n’y a aucune connaissance préalable de la performance de A ou B.

3. Faire le chemin à l’envers

Parfois, le problème de trafic n’a pas pour cause un site web à faible trafic, mais plutôt une page web. En effet, dans la plupart des cas, les pages avec un faible trafic se situent à la fin du funnel d’achat.

Dans ce cas, une excellente stratégie consiste à travailler sur l’optimisation de celui-ci. Une première solution peut se trouver en cherchant à optimiser le parcours client digital tout au long du funnel.

4. Est-ce que la technique CUPED fonctionne vraiment ?

Qu’est-ce que CUPED ?

Controlled Experiment Using Pre-Experiment Data est un terme à la mode dans le domaine de l’expérimentation. CUPED est une technique qui prétend produire des résultats jusqu’à 50% plus rapidement. Cela est très attrayant pour les sites Web à faible trafic.

Est-ce que CUPED fonctionne vraiment aussi bien ?

Pas exactement, pour deux raisons : l’une est organisationnelle et l’autre est liée à son application.

La contrainte organisationnelle

Ce qui est souvent oublié, c’est que CUPED signifie Controlled experiment Using Pre-Experiment Data.

En pratique, la période idéale pour collecter des « Pre-Experiment Data » est de deux semaines pour espérer une réduction de temps de 50%.

Ainsi, pour un test classique de 2 semaines, CUPED prétend que vous pouvez mettre fin au test en seulement 1 semaine.

Cependant, pour pouvoir observer correctement vos résultats, vous aurez besoin de deux semaines de données pré-expérimentation. En réalité, vous devez donc disposer de trois semaines pour mettre en œuvre CUPED afin d’obtenir la même précision qu’un test classique de 2 semaines.

Oui, vous avez bien lu. En fin de compte, vous aurez besoin de trois semaines pour mener à bien une expérimentation.

En d’autres termes, cette méthode n’est utile que si vous disposez déjà de deux semaines de données de trafic non exposées à une quelconque expérience. Mais si vous pouvez planifier deux semaines sans expérimentations dans votre roadmap pour collecter des données, cela bloquera le trafic pour d’autres expériences.

La contrainte d’application

En plus de la contrainte organisationnelle/liée à la période des deux semaines, il existe deux autres prérequis pour que CUPED soit efficace :

- CUPED s’applique uniquement aux visiteurs parcourant le site à la fois pendant la période de pré-expérimentation et la période expérimentale.

- Ces visiteurs doivent avoir le même comportement par rapport au KPI. Les données des visiteurs doivent être corrélées entre les deux périodes.

Vous constaterez dans le paragraphe suivant que ces deux contraintes rendent CUPED pratiquement impossible pour les sites de e-commerce et ne s’appliquent qu’aux plateformes.

Revenons à notre exemple de configuration d’expérimentation :

- Deux semaines de données pré-expérimentation.

- Deux semaines de données d’expérimentation (que nous espérons ne durer qu’une semaine grâce à la réduction de temps de 50% supposée).

- L’objectif d’optimisation est une transaction : augmenter le nombre de conversions.

La contrainte numéro 1 stipule qu’il faut avoir les mêmes visiteurs pendant la période de pré-expérimentation et d’expérimentation. Or, le parcours du visiteur dans le secteur du e-commerce dure généralement une semaine.

En d’autres termes, il y a très peu de chances que vous voyiez les mêmes visiteurs dans les deux périodes. Ainsi, on ne peut s’attendre qu’à un effet très limité de CUPED (limité à la portion de visiteurs observés dans les deux périodes).

La contrainte numéro 2 stipule que les visiteurs doivent avoir le même comportement en ce qui concerne la conversion (par rapport au KPI en cours d’optimisation). Honnêtement, cette contrainte n’est tout simplement jamais respectée dans le e-commerce.

La conversion dans le e-commerce se produit soit pendant la période de pré-expérimentation, soit pendant la période expérimentale, mais pas dans les deux cas (à moins que votre client effectue fréquemment plusieurs achats pendant la période de l’expérience).

Cela signifie qu’il n’y a aucune chance que les conversions des visiteurs soient corrélées entre les périodes.

En résumé : CUPED n’est tout simplement pas applicable aux sites e-commerce pour optimiser les transactions.

Cela est clairement indiqué dans l’article scientifique d’origine, mais dans un souci de popularité, cette technique de buzzword est présentée de manière erronée dans l’industrie des tests.

En réalité, CUPED fonctionne uniquement pour les conversions multiples sur des plateformes qui ont des visiteurs récurrents effectuant les mêmes actions.

Les grandes plateformes adaptées à CUPED seraient les moteurs de recherche (comme Bing, où il a été inventé) ou les plateformes de streaming où les utilisateurs viennent quotidiennement et effectuent les mêmes actions répétées (lecture d’une vidéo, clic sur un lien dans une page de résultats de recherche, etc.).

Mais si vous essayez de trouver une application de CUPED dans le domaine du e-commerce, vous vous rendrez rapidement compte que ce n’est tout simplement pas possible.

- On pourrait essayer d’optimiser le nombre de produits consultés, mais le problème de la contrainte 1 reste applicable : un très petit nombre de visiteurs sera présent dans les deux ensembles de données. De plus, il y a une objection encore plus fondamentale : ce KPI ne devrait pas être optimisé en lui-même, sinon vous encouragez potentiellement l’hésitation entre les produits.

- Vous ne pouvez même pas essayer d’optimiser le nombre de produits achetés par les visiteurs avec CUPED car la contrainte numéro 2 reste valable. L’acte d’achat peut être considéré comme instantané. Par conséquent, il ne peut se produire que dans une période ou l’autre, pas les deux. S’il n’y a pas de corrélation attendue dans le comportement des visiteurs, il n’y a alors aucun effet CUPED à attendre.

Conclusion sur CUPED

En conclusion, CUPED ne fonctionne pas pour les sites de e-commerce où une transaction est l’objectif principal d’optimisation. À moins d’être Bing, Google ou Netflix, CUPED ne sera pas l’ingrédient secret pour vous aider à optimiser votre activité.

Cette technique est certainement un mot à la mode qui suscite rapidement l’intérêt. Cependant, il est important d’avoir une vision plus globale avant de vouloir ajouter CUPED à votre feuille de route. Les marques de e-commerce devront prendre en compte le fait que cette technique de test ne convient pas à leur entreprise.

Optimisation pour les sites à faible trafic

Les marques ayant un faible trafic sont toujours des candidats privilégiés pour l’optimisation de leur site web, même si elles doivent adopter une approche légèrement différente de la méthode traditionnelle.

Que cela implique de choisir une page plus haut dans le funnel d’achat ou d’adopter un seuil de certitude légèrement plus bas, l’optimisation continue est cruciale.

Vous souhaitez commencer à optimiser votre site Web ? AB Tasty est la plateforme d’optimisation de l’expérience best-in-class qui vous permet de créer une expérience digitale enrichie rapidement. De l’expérimentation à la personnalisation, cette solution peut vous aider à activer et à engager votre public pour stimuler vos conversions.

Vous pouvez trouver le lien de l’article original ici.